CODEFUSION 코드퓨전

마이크로소프트웨어의 copilot에서 코드 생성에 쓰일 수도 있는 논문인 것 같다. arXiv에 최초 공개되었던 표에는 ChatGPT에 파라미터가 20B 이라고 표시했다가 지워졌다는 얘기가 있다. 현재는 arXiv에는 다운받을 수 없고 MS의 Reseach에서 다운 받을 수 있는 논문에는 Unknown으로 표시되어 있다. 파라미터 200억개로 여러 언어를 학습하는 게 가능한가 하는 개발자들 사이에 의문이 있다. 하지만 나의 관심은 평가에 사용된 지표이다.

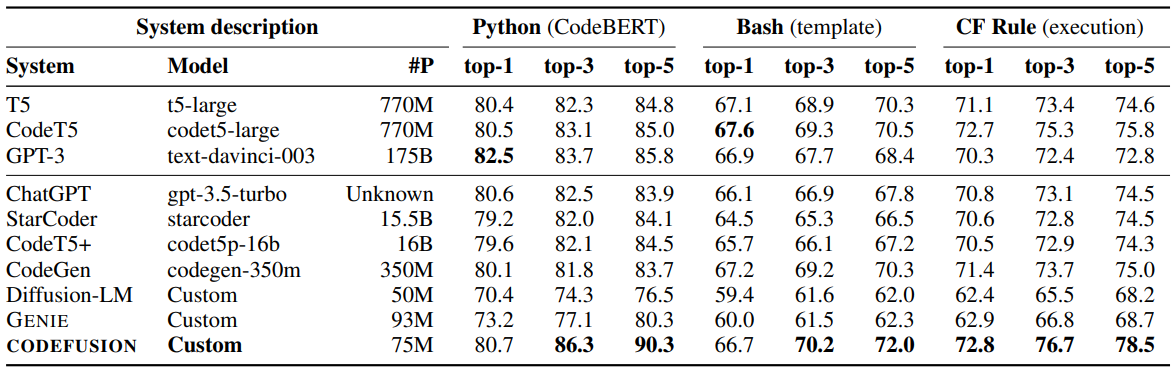

Metrics

Evaluation

- (Bash generation) template match metric

- (Python) CodeBERTScore

- Microsoft Excel conditional formatting (CF) execution match

Generation diversity

- count of distinct token n-grams

- summary statistics over pairwise similarities of CodeBERT encodings

- summary statistics over pairwise string edit distances

AI 모델의 크기를 나타내는 파라미터 갯수에 따라서 성능이 비례하는 것은 사실이고, 파라미터 갯수를 최적화할 필요가 있다. Pruning하고 Quantization하는 방법들이 연구되고 있다.

- We propose CODEFUSION, the first diffusionbased NL-to-code model.

- We adapt continuous paragraph denoising (CPD) to code and show that it substantially improves the results of CODEFUSION.

- We compare CODEFUSION to auto-regressive code models and text diffusion models on the NL-to-code task in three languages

CODEFUSION: A Pre-trained Diffusion Model for Code Generation - Microsoft Research (2023.11.)

CODEFUSION: A Pre-trained Diffusion Model for Code Generation - Microsoft Research

Imagine a developer who can only change their last line of code — how often would they have to start writing a function from scratch before it is correct? Auto-regressive models for code generation from natural language have a similar limitation: they do

www.microsoft.com

MS 코파일럿

MS Copilot 마이크로소프트 코파일럿

A whole new way to work Introducing Microsoft 365 Copilot | Microsoft 365 BlogCopilot combines the power of language models with your data in the Microsoft 365 apps and Microsoft Graph to turn your words into the most powerful productivity tool on the plan

dase.tistory.com